状态值函数的形式化定义

1. 前提条件与数学符号

我们首先假定系统基于一个标准马尔可夫决策过程 (Markov Decision Process, MDP),其动力学是时间齐次 (time-homogeneous) 的,即转移概率不随时间变化。

- : 时刻 的状态 (State)。

- : 时刻 获得的奖励 (Reward)。

- : 策略 (Policy),一个从状态到动作的映射,通常是随机的,即 。我们假定这是一个平稳策略 (stationary policy),即 不随 变化。

- : 时刻 的回报 (Return),通常是折扣化的累积奖励: 其中 是折扣因子。

- : 期望操作符。

- : 在遵循策略 下的期望。

2. 定义(公式 2.5)的解析

公式 (2.5) 定义了状态值函数 :

是在给定遵循策略 的条件下,从状态 开始所能获得的期望回报。它量化了在特定策略 下,从状态 出发所具有的“好”或“坏”的程度。

数学基础:条件期望

状态值函数本质上是一个条件期望 。

- 随机变量 是回报 。

- 条件事件 是起始状态 。

由于 是未来随机奖励序列的函数,它本身是一个随机变量。通过求条件期望,我们得到了一个确定的数值,这个数值仅仅是状态 和策略 的函数。

状态值函数的三个关键性质的深入分析

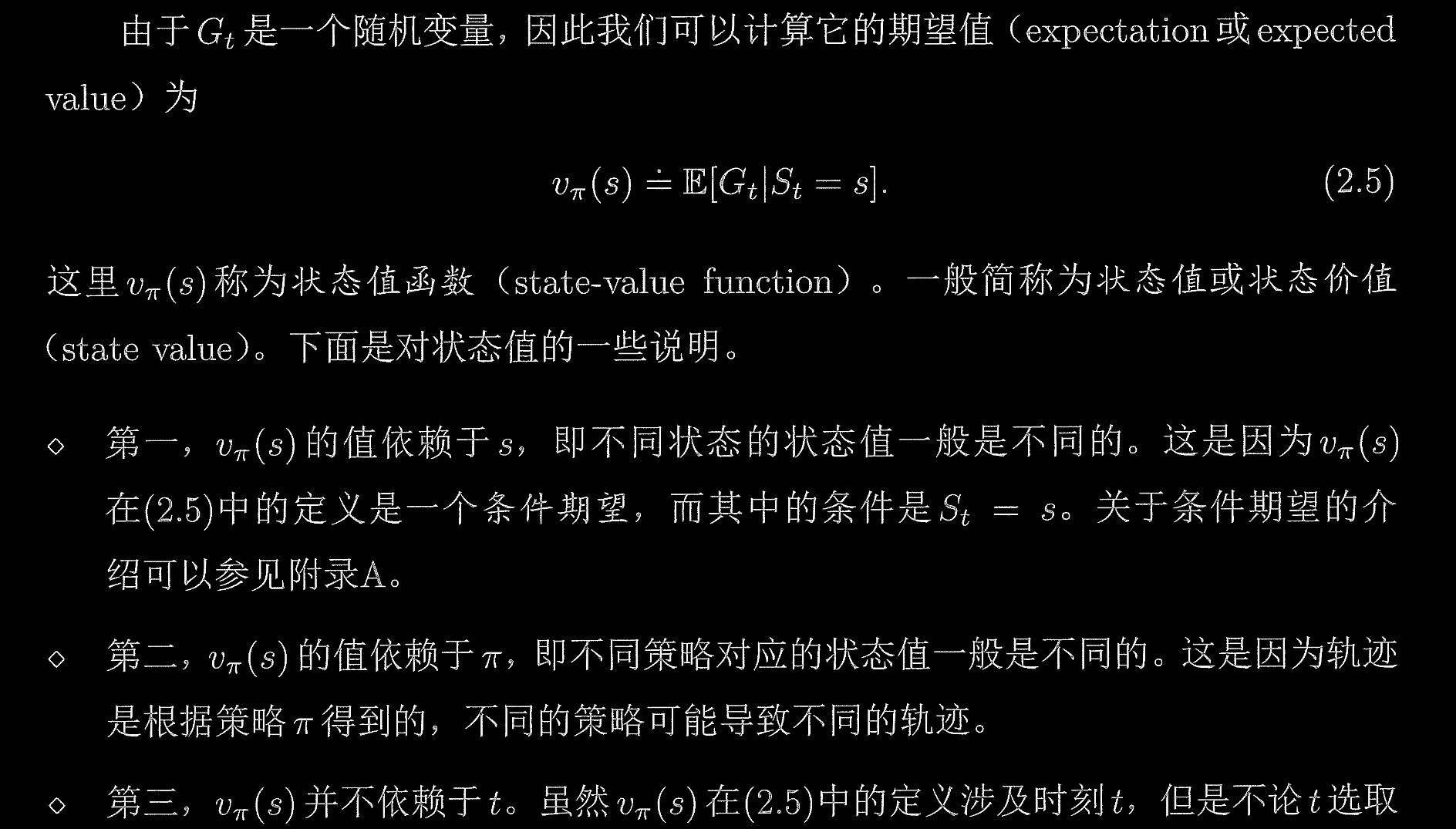

图片(来自强化学习的数学原理一书)中列出了三条性质。

性质一: 依赖于状态

解释: 是一个函数,它将状态空间 中的每一个状态映射到一个实数值。

依赖关系直接来源于条件期望的定义 。当 时,两个条件期望 和 是基于不同的初始条件进行计算的。

在 MDP 中,不同的状态 通常意味着:

- 不同的即时奖励分布: 可能不同。

- 不同的未来转移可能性: 可能不同。

因此,固定策略 后,从 开始和从 开始的期望轨迹是不同的,故 是普遍情况。

性质二: 依赖于策略

解释: 策略 决定了在状态 之后,系统将如何演化,从而直接影响了回报 的分布。

策略 是一个条件概率分布 。当我们在计算期望 时,这个期望是在由 诱导的(即遵循 产生的)概率测度下计算的。

轨迹 的概率 依赖于两个因素:

- MDP的转移核: (环境决定)。

- 策略 (智能体决定)。

如果存在两个不同的策略 ,即使它们从同一状态 开始,由于 和 选择了不同的动作分布,导致了不同的未来状态和奖励序列分布。

结论: 状态值函数是评价特定策略好坏的指标,因此它必须依赖于 。

性质三: 不依赖于时刻

解释: 尽管公式 (2.5) 中出现了时间指标 ,但只要 ,那么这个期望值与 的具体数值无关。这是强化学习理论中平稳性 (stationarity) 的直接体现。

在标准 RL 框架(即离散时间、折扣、时间齐次 MDP)中,我们有以下两个关键假设:

1. 策略的平稳性 (Stationary Policy)

我们假定使用的策略 是平稳的,即 不依赖于绝对时间 。

2. MDP的齐次性 (Time-Homogeneous Dynamics)

环境的转移概率不依赖于绝对时间 。

3. 期望的推导

我们来考察 的定义:

现在,考虑两个不同时刻 和 ,但它们都从相同的状态 开始。

在时刻 的定义:

在时刻 的定义:

由于 MDP 的动力学 和策略 都与绝对时间 无关,从状态 开始的任何未来子序列的概率分布都只依赖于这个子序列的相对时间步长 。

具体来说,在 的条件下: 这个联合概率分布函数是完全由 、 和 决定的,与 的具体数值无关。

因此,回报 的概率分布 与 的概率分布 是相同的。

由于两个随机变量(回报)的条件概率分布一致,它们的期望值也必然一致:

在平稳策略和时间齐次 MDP的假设下,状态值函数 是一个时间无关的量,它只依赖于你当前所处的空间位置 ,而不依于你处于该位置的绝对时刻 。这就是为什么我们在 的表示中通常省略了对 的依赖。