贝尔曼期望方程的起点

状态值函数 vπ(s) 的递归定义,即贝尔曼期望方程 (Bellman Expectation Equation),是基于回报 Gt 的递归结构:

Gt=Rt+1+γGt+1

将状态值函数的定义 vπ(s)≐Eπ[Gt∣St=s] 代入,并利用期望的线性性质,我们得到公式 (2.6)(未在图片中显示,但作为起点):

vπ(s)=Eπ[Rt+1+γGt+1∣St=s]

vπ(s)=E[Rt+1∣St=s]+γE[Gt+1∣St=s](2.6)

这个方程将 vπ(s) 分解成了两部分:即时奖励的期望和未来折扣回报的期望。

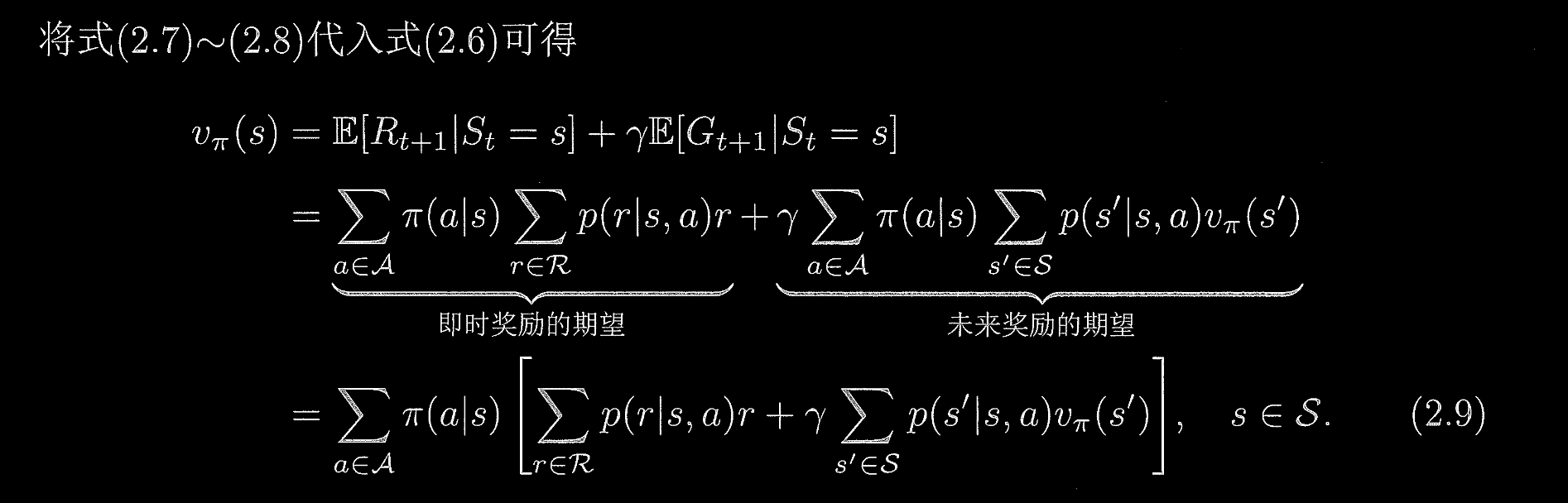

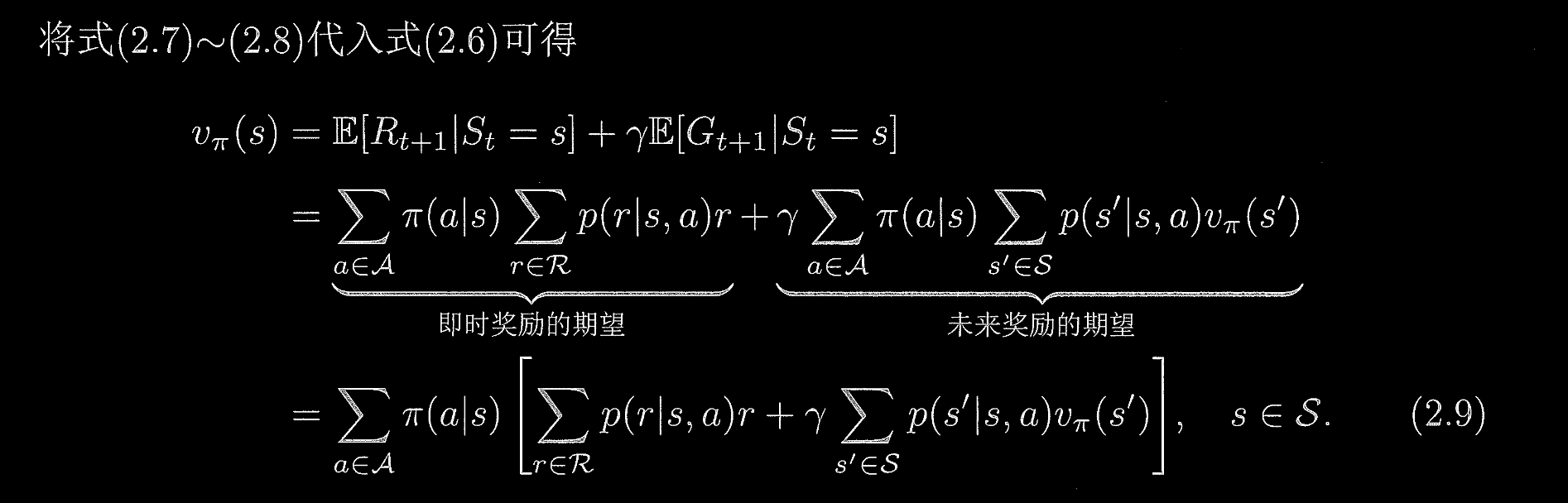

从 (2.6) 到 (2.9) 的分解

推导 (2.9) 的过程是将公式 (2.6) 右侧的两项进行展开和计算。

1. 展开第一项:即时奖励的期望

这部分正是我们在上一个问题关于状态值中推导过的公式 (2.7)。它计算的是从状态 s 出发,在策略 π 下的即时期望奖励。

E[Rt+1∣St=s]=∑a∈Aπ(a∣s)∑r∈Rp(r∣s,a)r

2. 展开第二项:未来折扣回报的期望

我们需要计算 γE[Gt+1∣St=s]。

2.1 引入中间变量 At 和 St+1

与第一项类似,我们先引入 At 的条件期望:

E[Gt+1∣St=s]=∑a∈AP(At=a∣St=s)E[Gt+1∣St=s,At=a]

E[Gt+1∣St=s]=∑a∈Aπ(a∣s)E[Gt+1∣St=s,At=a]

接着,我们引入下一状态 St+1=s′ 作为条件,利用全期望定律:

E[Gt+1∣St=s,At=a]=∑s′∈SP(St+1=s′∣St=s,At=a)E[Gt+1∣St=s,At=a,St+1=s′]

2.2 利用马尔可夫性和值函数定义

- 马尔可夫性 (Markov Property): MDP要求未来的状态和回报只依赖于当前状态和动作,而与历史状态无关。因此:

E[Gt+1∣St=s,At=a,St+1=s′]=E[Gt+1∣St+1=s′]

- 状态值函数定义 vπ(s) 的时间齐次性 (Time-Homogeneity): 根据前一个问题的结论(vπ(s) 不依赖于 t):

E[Gt+1∣St+1=s′]=vπ(s′)

- 转移概率: 从 (s,a) 转移到 s′ 的概率,记为 p(s′∣s,a)。

P(St+1=s′∣St=s,At=a)=∑r∈Rp(s′,r∣s,a)=p(s′∣s,a)

将这些代入,第二项变为:

E[Gt+1∣St=s,At=a]=∑s′∈Sp(s′∣s,a)vπ(s′)

2.3 完整的第二项

γE[Gt+1∣St=s]=γ∑a∈Aπ(a∣s)∑s′∈Sp(s′∣s,a)vπ(s′)

3. 合并得到 (2.9)

将第一项和第二项合并代回 (2.6),我们得到中间的等式(带两个大括号):

vπ(s)=即时奖励的期望a∈A∑π(a∣s)r∈R∑p(r∣s,a)r+γ未来奖励的期望a∈A∑π(a∣s)s′∈S∑p(s′∣s,a)vπ(s′)

最后,由于两个主要项都包含了对动作 a 的外部求和 ∑a∈Aπ(a∣s),我们可以将其提取到最外层,得到公式 (2.9):

vπ(s)=a∈A∑π(a∣s)[r∈R∑p(r∣s,a)r+γs′∈S∑p(s′∣s,a)vπ(s′)](2.9)

状态 s 的价值 vπ(s) 等于:

- 智能体在 s 处可能采取的每一个动作 a 的概率加权平均。 (∑a∈Aπ(a∣s))

- 对于每一个动作 a,其对应的期望价值是:即时获得的期望奖励 (∑r∈Rp(r∣s,a)r) 加上 下一状态 s′ 的价值 vπ(s′) 经过折扣和转移概率加权平均后的期望值 (γ∑s′∈Sp(s′∣s,a)vπ(s′))。

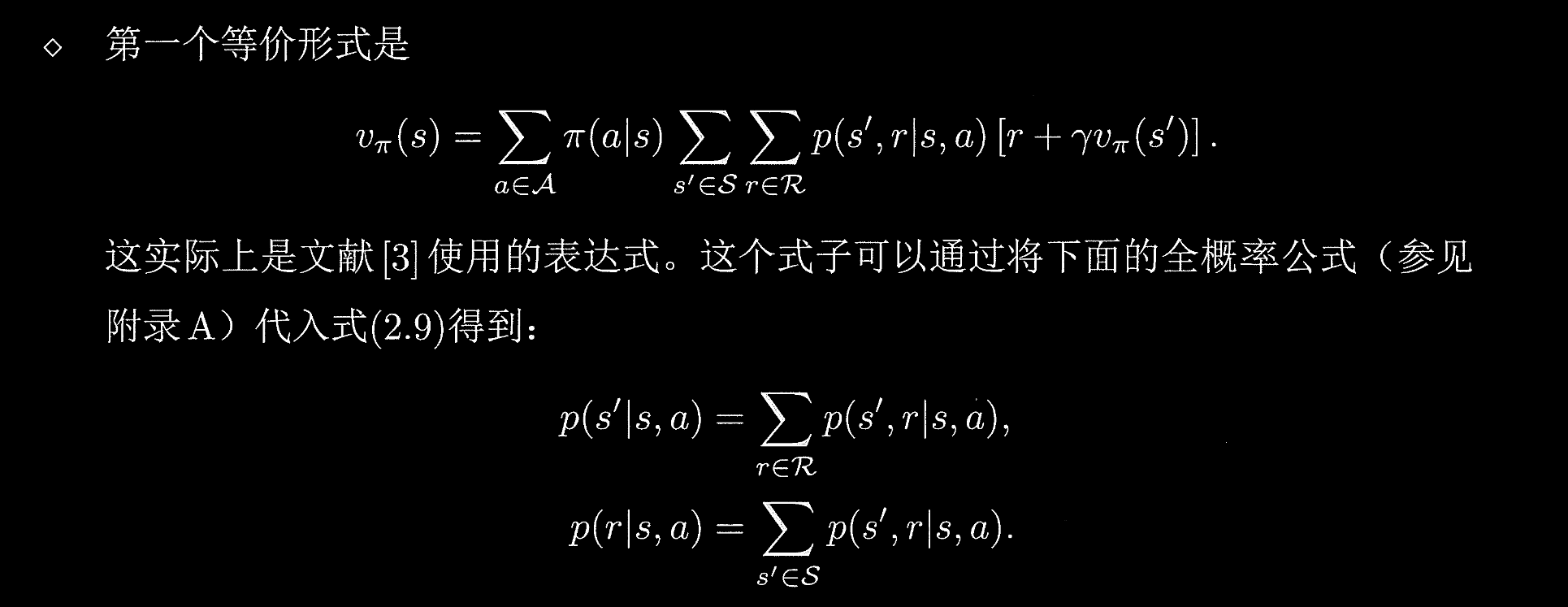

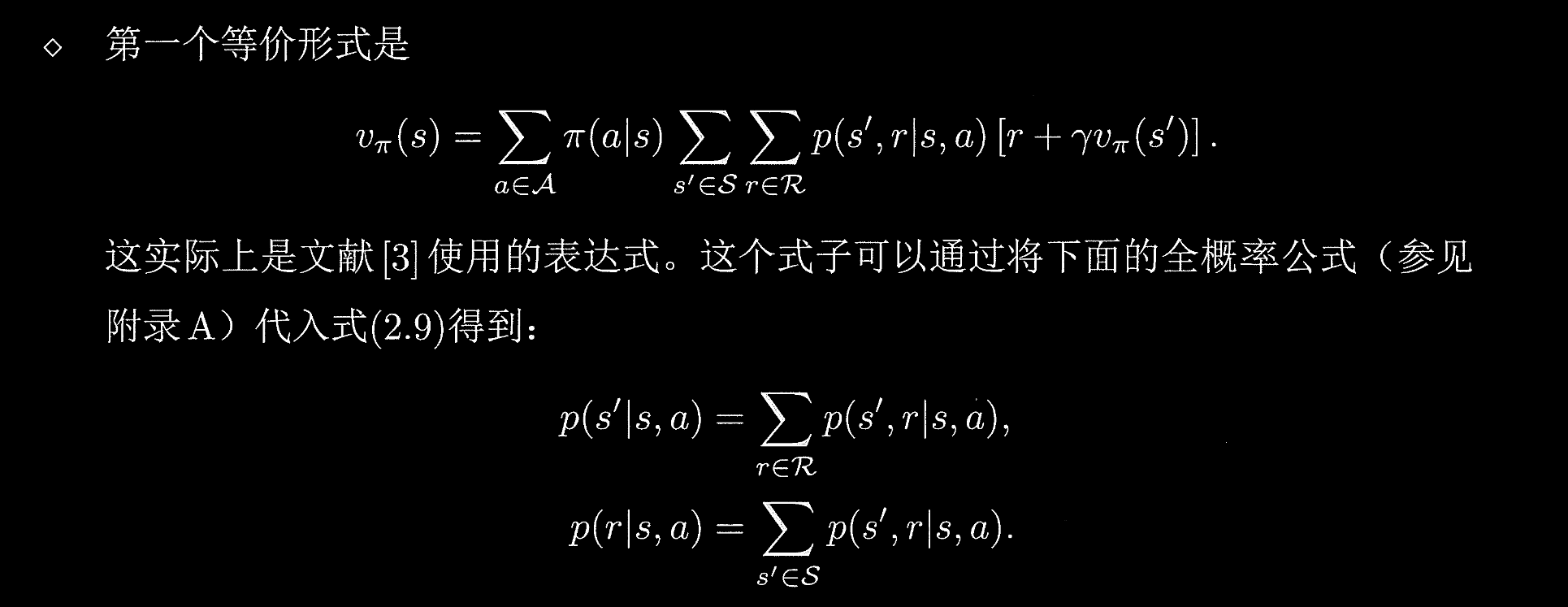

贝尔曼方程的另一种形式

强化学习的数学原理书中提到了 vπ(s) 的另一个等价形式:

vπ(s)=a∈A∑π(a∣s)s′∈S∑r∈R∑p(s′,r∣s,a)[r+γvπ(s′)]

这个形式是更普遍和紧凑的,它直接利用了 MDP 的联合转移概率 p(s′,r∣s,a)。

概率基础:联合转移概率 p(s′,r∣s,a)

在标准的 MDP 定义中,联合概率 p(s′,r∣s,a) 是指在状态 s 采取动作 a 后,转移到状态 s′ 并获得奖励 r 的概率:

p(s′,r∣s,a)≐P(St+1=s′,Rt+1=r∣St=s,At=a)

书中提供的两个全概率公式(边缘概率)正是将 p(s′,r∣s,a) 与公式 (2.9) 中使用的 p(s′∣s,a) 和 p(r∣s,a) 联系起来的桥梁:

- 下一状态的边缘概率:

p(s′∣s,a)=∑r∈Rp(s′,r∣s,a)

(对所有可能的奖励 r 求和,得到转移到 s′ 的总概率。)

- 即时奖励的边缘概率:

p(r∣s,a)=∑s′∈Sp(s′,r∣s,a)

(对所有可能的下一状态 s′ 求和,得到获得奖励 r 的总概率。)

推导

我们从贝尔曼方程的紧凑形式开始验证它与 (2.9) 的等价性:

vπ(s)=a∈A∑π(a∣s)s′∈S∑r∈R∑p(s′,r∣s,a)[r+γvπ(s′)]

展开内部中括号:

vπ(s)=a∈A∑π(a∣s)[s′∈S∑r∈R∑p(s′,r∣s,a)r+γs′∈S∑r∈R∑p(s′,r∣s,a)vπ(s′)]

现在利用边缘概率公式进行化简:

对于第一项(即时奖励):

∑s′∈S∑r∈Rp(s′,r∣s,a)r=∑r∈Rr即 p(r∣s,a)s′∈S∑p(s′,r∣s,a)=∑r∈Rrp(r∣s,a)

这与公式 (2.9) 中即时奖励部分相符。

对于第二项(未来价值):

γ∑s′∈S∑r∈Rp(s′,r∣s,a)vπ(s′)=γ∑s′∈Svπ(s′)即 p(s′∣s,a)r∈R∑p(s′,r∣s,a)=γ∑s′∈Sp(s′∣s,a)vπ(s′)

这与公式 (2.9) 中未来奖励部分相符。

结论: 两种形式 (2.9) 和其变体是完全等价的,只是在组织转移概率项时采用了不同的分解方式。变体形式更强调 s→(s′,r) 这一联合事件 的概率。